ニュース

「ChatGPT」のような生成系AIを高速化するサーバー向けGPUをNVIDIAが発表

|

本稿では,基調講演の一部から,ゲーマーでも知っておく価値がありそうなものにしぼって概要を紹介したい。

計算機リソグラフィ分野に大躍進をもたらす「cuLitho」

NVIDIAは自社で工場を持たない,いわゆるファブレスの半導体メーカーである。ただ,ファブレスといっても半導体の製造技術と無関係でいられるわけではない。とくにGPUは,最先端の製造技術を用いる複雑で大規模な半導体だ。それだけに,NVIDIAは,TSMCをはじめとする半導体受託製造企業と緊密に連携して,製品の開発を行ってきた。

GTC 2023では,NVIDIAと製造パートナーによる長年の研究成果である半導体製造技術向けのソフトウェアライブラリ「cuLitho」が発表となった。cuLithoは,NVIDIAが「計算機リソグラフィにブレークスルーをもたらす」と誇らしげにアピールする技術だ。

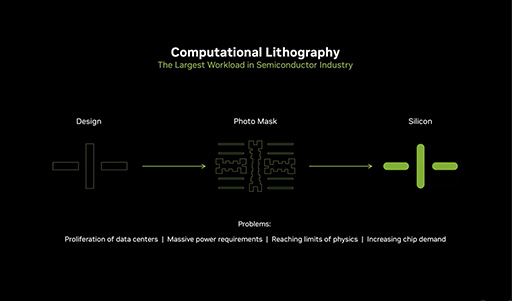

cuLithoを紹介する前に,「計算機リソグラフィとはなんぞや」という点に触れておこう。現在のプロセッサやメモリは,光学的な写真製版技術を使って製造している。電子回路のパターンを生成して,それを露光剤を塗布したシリコンの板(ウェハ)に光学的な方法で転写し,エッチングを行って形成するという方式だ。

説明するだけなら簡単なのだが,現在の半導体は非常に微細化しているために,光の回折によって生じる像のボケが問題になる。回折は,光の波の性質によって生じるので,微細化するほど顕著になってしまう。回折による像のボケは,たとえば回路の線が細くなったり,逆に太くなったりするだけでなく,四角くしたいところが丸くなるといった回路パターンの歪みになって現れる。これは不良品を出してしまう大きな原因になるわけだ。

そこで,今どきの半導体製造においては,回折に起因する歪みを見越してマスクを作成する光学近接補正(Optical Proximity Correction:OPC)という技法が使われている。

|

OPCは,もちろん手作業などではなく,コンピュータを使って行う処理だ。OPCのようなコンピュータを使ったシミュレーションと図形補正を用いた手法を,計算機リソグラフィという。

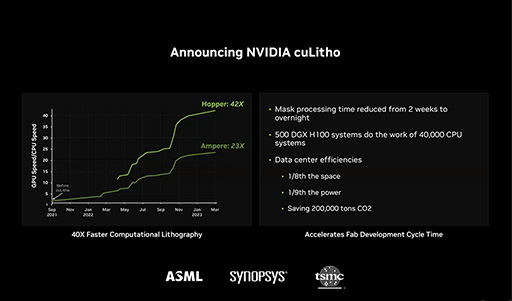

ようやく本題に入るのだが,NVIDIAは,GPUを使ってOPCの速度を大幅に引き上げるアルゴリズムを開発した。それがcuLithoである。どのくらい高速化できるかというと,「Hopper」ーキテクチャGPUのシステムを使用することにより,従来製品と比べて最大40倍にも達するそうだ。

|

cuLithoを用いることで,半導体開発にかかる期間を大幅に短縮できるうえ,計算で使うコンピュータのリソースも削減できるとのこと。そのため半導体製造に関わる二酸化炭素放出量も大幅に削減できるとNVIDIAはアピールする。

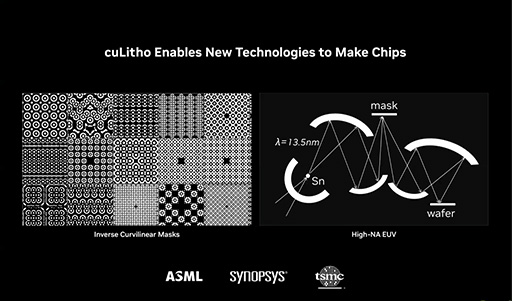

さらに,これまでは計算が極めて難しく,導入のハードルになっていたHigh NA EUV(高開口数極端紫外線)と非球面光学系を組み合わせたリソグラフ技術が「cuLithoによって実現可能になるだろう」とNVIDIAは予告した。これらの技術は,次世代のプロセスノードである3nmクラスを実現する鍵になると言われているものだ。

|

NVIDIAは,TSMCに加えて,半導体製造で用いる露光機でトップシェアを持つ企業のASMLや,半導体設計に関わるEDA分野でトップに立つSynopsysという業界を代表する3社をパートナーとして,cuLithoを推進していくそうだ。将来的には,TSMC以外の企業にもcuLithoを広げるとNVIDIAは述べていた。

NVIDIAにとってcuLithoは,GPUの市場を広げると同時に自社の開発を加速させるという,一石二鳥の技術というところだろうか。一般消費者には直接関係のない話題ではあるが,こうした技術で作られたGPUがいずれ市場にも登場すると考えれば,興味深い話題ではなかろうか。

Generative AIで波に乗るNVIDIA

まるで人間のように受け答えができるAIサービス「ChatGPT」がちょっとしたブームになっていることは,ゲーマーでも小耳に挟んだことがあるだろう。ChatGPTは,AIを研究する非営利団体のOpen AIが開発した大規模言語モデルをベースとするサービスだ。また,人が描いたような画像を出力する「Stable Diffusion」や,音楽を作るAIサービスなどが次々と登場している。これらのように,なんらかのコンテンツを生成する機能を持ったAIを,「Generative AI」という。Generative AIは,今まさにホットな分野であるが,それを実現する演算をこなしているのがGPUだ。なかでも,NVIDIA製GPUのシェアは大きいそうで,GTC 2023でも,Generative AIに関する発表が多数行われた。

Generative AIは,既存のビジネスを変える可能性を持っているが,いざ企業が導入しようとすると,多くのハードルが存在している。AIモデルのカスタマイズに時間がかかることも,そのひとつだ。ある企業の顧客サポートをAIチャットボットに置き換える場合,一般的な言語学習データだけではなく,これまでもその企業が蓄積してきたデータを加えてカスタマイズした大規模言語モデルを作成する必要がある。加えて,その言語モデルを実際に活用するにも計算資源が必要だ。

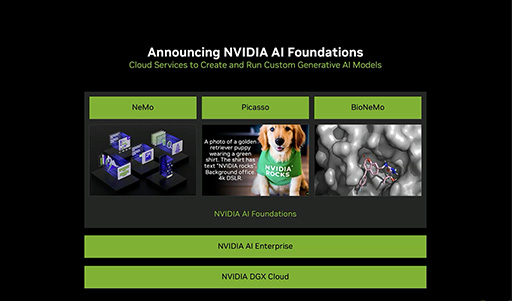

こうした課題の解決策としてNVIDIAが発表したのが,Generative AIの導入を支援する「NVIDIA AI Foundation」だ。NVIDIA AI Foundationは,AIモデルのカスタマイズと,それを利用するクラウドサービスを組み合わせたソリューションと考えればいいだろう。大規模言語モデルを扱う「NeMo」と,画像や3Dモデルを扱う「Picasso」,バイオテクノロジ向けの「BioNeMo」という3種類の要素を含んでいる。

|

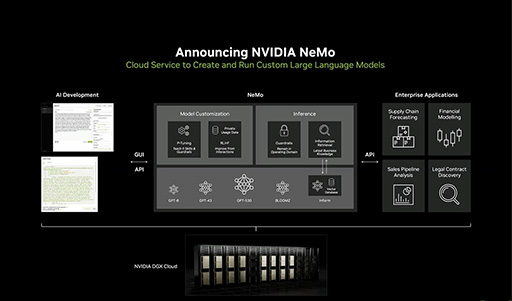

大規模言語モデルのNeMoでは,膨大なコーパス(さまざまな文章をまとめて整理したもの)を学習させた複数の言語モデルを,NVIDIAが提供する。企業はこれらの中から適切な言語モデルを選び,それに自社用のカスタマイズを加えるられるそうだ。そしてカスタマイズを加えたオリジナルの言語モデルを,クラウドで利用できるという。

|

NVIDIA AI Foundationを利用する企業は,NVIDIAのサポートを受けられるとのこと。企業にとって,Generative AIの導入を容易にするサービスとして注目を集めそうだ。

Generative AI向けに新しいアクセラレーターを投入

NVIDIA AI Foundationは,クラウドサービスを軸としたソフトウェア技術だが,NVIDIAはGTC 2023において,Generative AI向けのデータセンター用アクセラレータ計2製品を発表した。

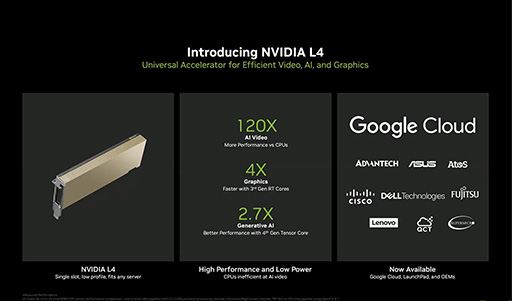

ひとつは,薄型フォームファクタが特徴の「NVIDIA L4」だ。

|

NVIDIAは,2022年に「Ada Lovelace」アーキテクチャベースのアクセラレータ製品「NVIDIA L40」を発売している。今回のNVIDIA L4は,その下位モデルとなる動画および静止画のGenerative AI向け製品である。

NVIDIAによると,NVIDIA L4はコンパクトな製品でありながら,動画のAI処理では,CPUと比べて120倍もの性能を持ち,多数の動画ストリームを同時にエンコードできるという。

NVIDIA L4は,「Google Cloud」が開発パートナーに挙げられており,まずGoogle Cloud上で機能が提供されるとのこと。その後,そのほかのシステムビルダーへ提供するそうだ。

もうひとつの製品は,大規模言語モデル向けにチューニングした「NVIDIA H100 NVL」である。

|

NVIDIA H100 NVLは,2022年3月に発表となったデータセンター向けGPU「H100」搭載製品のうち,PCI Express(以下PCIe)バージョンである「H100 PCIe」をもとに,2基のGPUをNVLinkで結合したものだ。

大規模言語モデルは,高速なメモリを大量に必要とする。そこで,NVIDIA H100 NVLは,高速かつ広帯域なHBM3メモリを採用しており,NVLinkで結合したトータルのグラフィックスメモリ容量は188GBに達するそうだ。NVIDIAは,本製品を導入することで,大規模言語モデルの実行や推論にかかるコストを大幅に削減できるとアピールしている。

Microsoft AzureがOmniverseを導入

Office 365との統合も

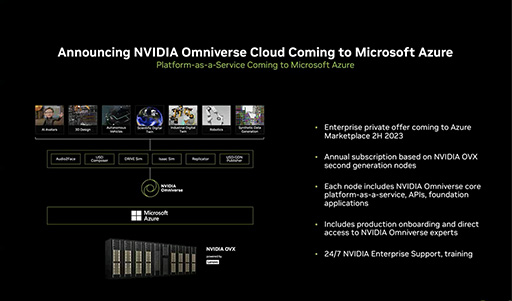

NVIDIAがかねてから力を入れて開発を進めている,3Dコラボレーションプラットフォーム「Omniverse」でも,いくつかの発表があった。とりわけ注目したいのは,Microsoftとの協業だろう。

Omniverseは,2023年第2半期を目処に,Microsoft Azureクラウド上に移行するそうだ。Microsoft Azureでは,OmniverseのためにNVIDIA製サーバーである「NVIDIA OVX」の第2世代製品を導入するとのことである。

|

さらに,OmniverseをOffice 365に統合するほか,Microsoft AzureのIoTインフラと相互接続することも計画しているそうだ。将来的には,たとえばTeamsの会議が,Omniverseで制作したバーチャル空間上で行われるようになるのかもしれない。

|

以上,GTC 2023における新発表のうち,興味深いものに絞って紹介した。これら以外にも,GTC 2023では多数のトピックが発表となっており,GPUに関するセッションも豊富に用意されている。ゲームに関するテーマは多くないが,興味がある人は,GTC 2023特設Webページをチェックしてみよう。

NVIDIAのGTC 2023特設ページ

NVIDIA日本語公式Webサイト

- 関連タイトル:

GeForce RTX 40

GeForce RTX 40

- この記事のURL: